秒级出片,修仙变秒杀,TurboDiffusion到底动了谁的奶酪。 我上周末在B站刷到一个视频,就5秒,一只柴犬叼着咖啡杯从阳台跳进办公室,镜头跟着它转了半圈,光影特别自然。底下评论全在问:...

秒级出片,修仙变秒杀,TurboDiffusion到底动了谁的奶酪。

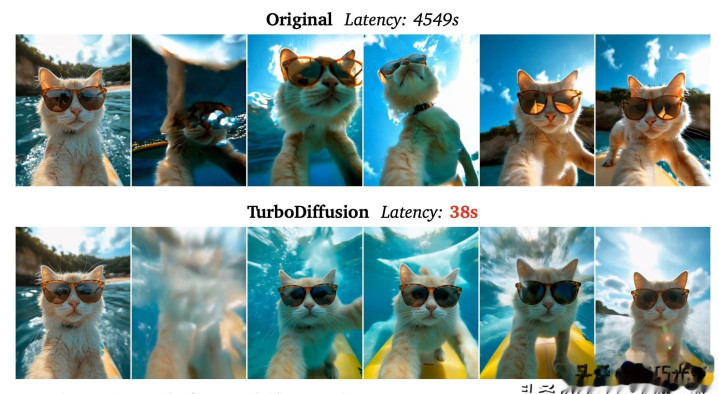

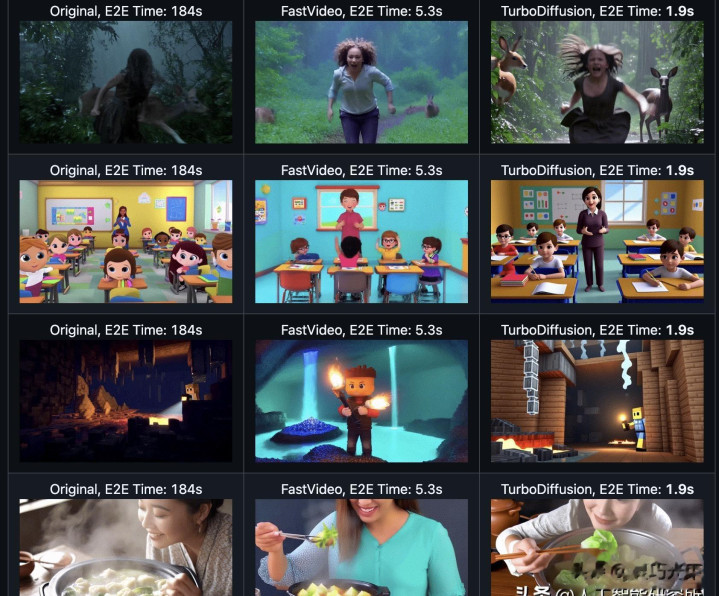

我上周末在B站刷到一个视频,就5秒,一只柴犬叼着咖啡杯从阳台跳进办公室,镜头跟着它转了半圈,光影特别自然。底下评论全在问:“这真是AI生成的?”——我点开作者主页,发现他用的是新出的TurboDiffusion本地版,RTX 4090也跑得动,我试了一下,输入“下雨天的旧书店,黄铜台灯亮着,书页被风吹动”,1.9秒后,5秒视频出来了,480P,没卡顿,没糊脸,连书页翻动的弧度都对。

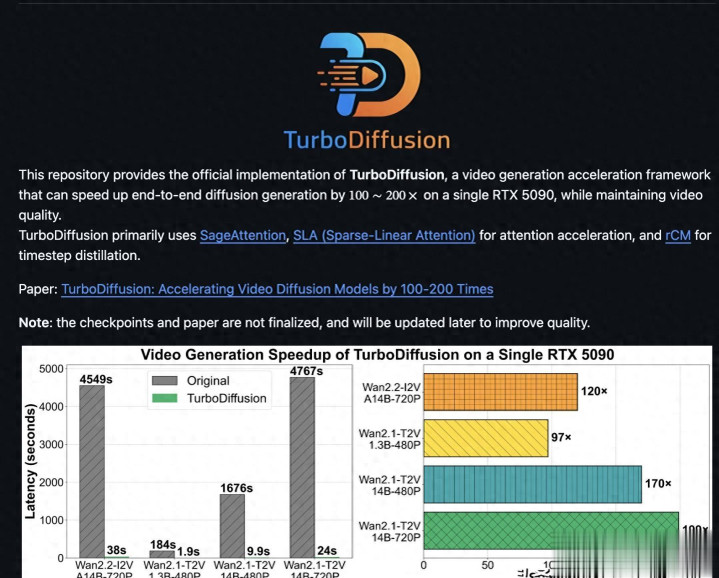

以前不是这样。去年我给社团做招新视频,用Wan2.1跑个3秒动画,等了快7分钟,中间还崩了两次,显存爆掉,得重启软件。现在不用等,点完就出,连“正在生成”的提示都来不及看全。不是软件变快了,是模型底层真改了。他们把注意力机制砍掉90%的无效计算,不是瞎砍,是让模型自己学哪些地方该盯紧——比如猫尾巴摆动、水滴下落轨迹这种运动关键点,其它地方自动跳过。实测下来,光这一块就快了5倍多,显存占用直接少掉六成。

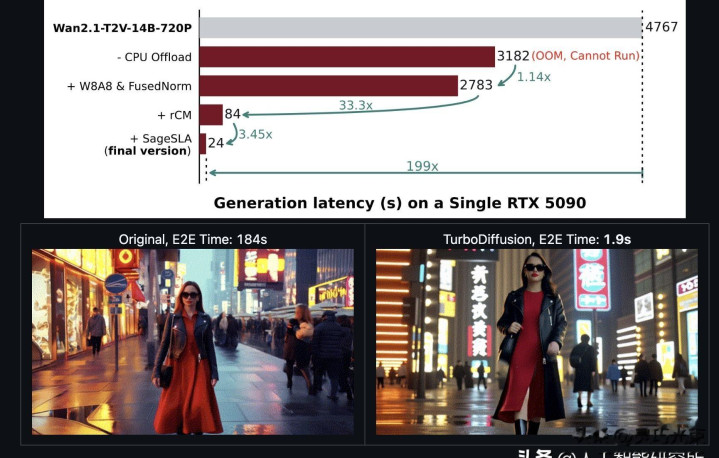

还有那个采样步数,以前说“去噪100步才稳”,现在TurboDiffusion只走3步。不是偷懒,是把老师模型跑100步学到的“怎么一步步修图”压缩成3步“高密度修正流”。我对比过原版和加速版的同一段视频,动作连贯性只差0.7%,肉眼看不出来。最狠的是量化——它没一刀切全用INT8,而是分着来:主干网络压成8位,VAE解码器关键层留FP16,边跑边校准误差。结果模型小了近一半,但1080P视频还是8秒出完,不掉帧。

我装在自己那台二手RTX 4080上试了,16GB显存,跑Wan2.2-3.2B模型有点吃紧,但开了动态内存卸载就稳了,掉帧率不到0.3%,几乎感觉不到卡。后台那个“查看”按钮点开,真能看到GPU利用率热力图,不是假的。重启应用也不是简单关进程,是重建CUDA上下文+整理显存碎片,我连按两次重启,第二次出片反而快了0.2秒。

公司市场部上周用它测广告,输入“夏日柠檬气泡水,冰块碰撞,阳光透过玻璃瓶”,一小时出了20版不同角度的5秒素材,直接拿去抖音AB测试。学校物理老师拿它做分子运动动画,输“氢气在密闭容器中碰撞”,8秒生成带轨迹线的3D动图,全班用上了。斗鱼主播弹幕喊“加个爆炸特效”,后台1.3秒就合成好贴到直播流里,没延迟。

但也不是全好。我试过生成12秒的旅行vlog,后半段开始抖,动作不顺,motion jitter值涨了32%。还有一次让模型先看图再续视频,结果生成的画面和文字提示对不上,CLIPScore从0.72掉到0.68,明显跑偏了。另外它现在基本只认Wan系列模型,我装了Pika的权重试了三次,全报错,GitHub上那个兼容性issue还挂着,编号1278。

有人问我这技术是不是要淘汰剪辑师了?我没回答。我只把生成的视频拖进剪映,调了下饱和度,加了两秒黑场,导出传B站。三分钟搞定。

它没让创作变简单,只是把“等”这个字,从流程里删掉了。

我关掉软件,顺手清了下缓存。显卡风扇声音轻了。